Jakie są najlepsze karty graficzne dla AI? Sprawdź!

Wybór karty graficznej do AI może przesądzić o tym, jak szybko przetrenujesz model albo przetworzysz dane. Jeśli chcesz świadomie dobrać sprzęt do zadań związanych ze sztuczną inteligencją, ten artykuł jest właśnie dla Ciebie. Wyjaśnię, które parametry karty graficznej mają znaczenie i pokażę konkretne modele, które sprawdzają się najlepiej w AI. Przygotuj się na konkretną dawkę wiedzy i wskazówek – to nie będzie kolejna ogólnikowa lista rekomendacji.

Najważniejsze informacje z tego artykułu:

- karta graficzna wykorzystywana w AI powinna mieć minimum 16 GB VRAM;

- rdzenie Tensor i technologia CUDA mają ogromny wpływ na wydajność AI;

- karty NVIDIA GeForce RTX, zwłaszcza 4090 i 4060 Ti 16 GB, dominują w testach AI;

- AMD oferuje więcej VRAM w niższej cenie, ale ustępuje NVIDIA w AI;

- Intel rozwija NPU i OpenVINO, jednak jeszcze nie dogania GPU w AI.

Jaka karta graficzna jest najlepsza do AI?

NVIDIA GeForce RTX 4090 to obecnie najmocniejszy wybór do AI, szczególnie w zadaniach opartych na głębokim uczeniu. Ma 24 GB VRAM, mnóstwo rdzeni CUDA i Tensor, a także obsługuje technologię Tensor RT.

W testach AI – takich jak UL Procyon czy Stable Diffusion – RTX 4090 uzyskuje najlepsze rezultaty. Jeśli budżet nie pozwala na ten model, RTX 4060 Ti 16 GB jest rozsądną alternatywą na start.

Z doświadczenia wiem, że karty graficzne odgrywają ogromną rolę już na wczesnym etapie prototypowania modeli. W testach, które przeprowadzam z wykorzystaniem frameworków jak TensorFlow i PyTorch, różnice między modelami GPU widać błyskawicznie – szczególnie w czasie trenowania i wnioskowania.

Karty AMD, jak RX 7900 XTX z 24 GB VRAM, też oferują sporą ilość pamięci. Jednak w benchmarkach AI zauważalnie ustępują kartom NVIDIA – zwłaszcza w obliczeniach całkowitoliczbowych.

Jakie parametry karty graficznej są najważniejsze dla AI?

Najważniejsze znaczenie mają cztery cechy – ilość pamięci VRAM, obecność rdzeni Tensor (lub ich odpowiedników), wydajność obliczeniowa i przepustowość pamięci. Ilość VRAM wpływa bezpośrednio na to, z jakimi modelami i danymi jesteś w stanie pracować. Minimum dla poważnego działania z AI to 16 GB VRAM – poniżej tego napotkasz wiele ograniczeń.

Rdzenie CUDA i Tensor przyspieszają uczenie modeli, bo umożliwiają przetwarzanie tysięcy wątków jednocześnie.

Przepustowość pamięci, mierzona w GB/s, określa, jak szybko dane trafiają do GPU – czym większa, tym lepiej. Wydajność obliczeniową mierzy się zazwyczaj w TFLOPS – czyli bilionach operacji zmiennoprzecinkowych na sekundę.

Wskazówka: Zawsze sprawdzaj nie tylko ilość pamięci VRAM, ale też typ – GDDR6X będzie szybszy od GDDR6 przy tej samej pojemności.

Jakie karty graficzne sprawdzają się najlepiej w AI?

Najlepiej wypadają karty NVIDIA GeForce RTX – od modelu 4060 Ti 16 GB w górę. RTX 4080 i 4090 dominują prawie wszystkie benchmarki AI, np. Geekbench ML czy UL Procyon Vision i Image Generation. NVIDIA oferuje także technologię Tensor RT, która przyspiesza operacje AI, szczególnie dla danych typu INT8 i FP16.

AMD z kolei stawia na otwartą platformę ROCm. Ich jednostki graficzne, jak RX 7900 XTX, dysponują dużą ilością VRAM-u i nieźle radzą sobie w testach float32 i float16. Mimo to pozostają za kartami GeForce, zwłaszcza gdy chodzi o integer performance (liczby całkowite).

Intel rozwija z kolei zintegrowane jednostki NPU w procesorach Meteor Lake i wysokowydajne zintegrowane grafiki Arc.

Na ten moment te rozwiązania są mniej wydajne, ale mogą być dobrą opcją do testowania modeli lub aplikacji w środowiskach niskich mocy.

Jakie są realne korzyści z karty graficznej dedykowanej AI?

Dobrze dobrana karta graficzna skraca czas trenowania modeli, pozwala na jednoczesne eksperymenty z wieloma architekturami oraz przyspiesza wnioskowanie w czasie rzeczywistym. W projektach, które współprowadzę, zastosowanie GPU skraca czas trenowania nawet 10-krotnie względem CPU.

Oprócz tego zyskujesz stabilność – karty stworzone z myślą o AI rzadziej się przegrzewają czy powodują bottlenecks. Jeśli karta ma solidne chłodzenie i obsługuje nowe biblioteki AI, możesz trenować przez całą noc bez obaw o stabilność pracy. Dzięki ekosystemowi CUDA i TensorFlow karty NVIDIA zapewniają najlepsze wsparcie deweloperskie.

Dostajesz też coś, czego nie widać na papierze – większy komfort pracy. Wysokowydajna karta zapewni szybkie renderowanie wizualizacji, eksperymentów i przetwarzanie wyników.

Jakie technologie wspierają karty graficzne do AI?

NVIDIA oferuje kompletny pakiet – CUDA, TensorRT, cuDNN – który integruje się z najpopularniejszymi bibliotekami ML jak PyTorch czy TensorFlow. Dzięki temu, karta GeForce RTX staje się czymś więcej niż tylko GPU – to element całego środowiska AI.

AMD rozwija ROCm – otwartą platformę, która coraz lepiej radzi sobie z integracją z popularnymi frameworkami uczenia maszynowego. Dla użytkowników Linuxa AMD może być tańszą alternatywą przy założeniu zgodności ze sterownikami i bibliotekami.

Intel skupia się na OpenVINO – technologii przetwarzania danych wizualnych i efektywnego wnioskowania AI na procesorach CPU, NPU i VPU.

Podejście to jest ciekawe, szczególnie przy aplikacjach edge’owych i o niskim poborze mocy.

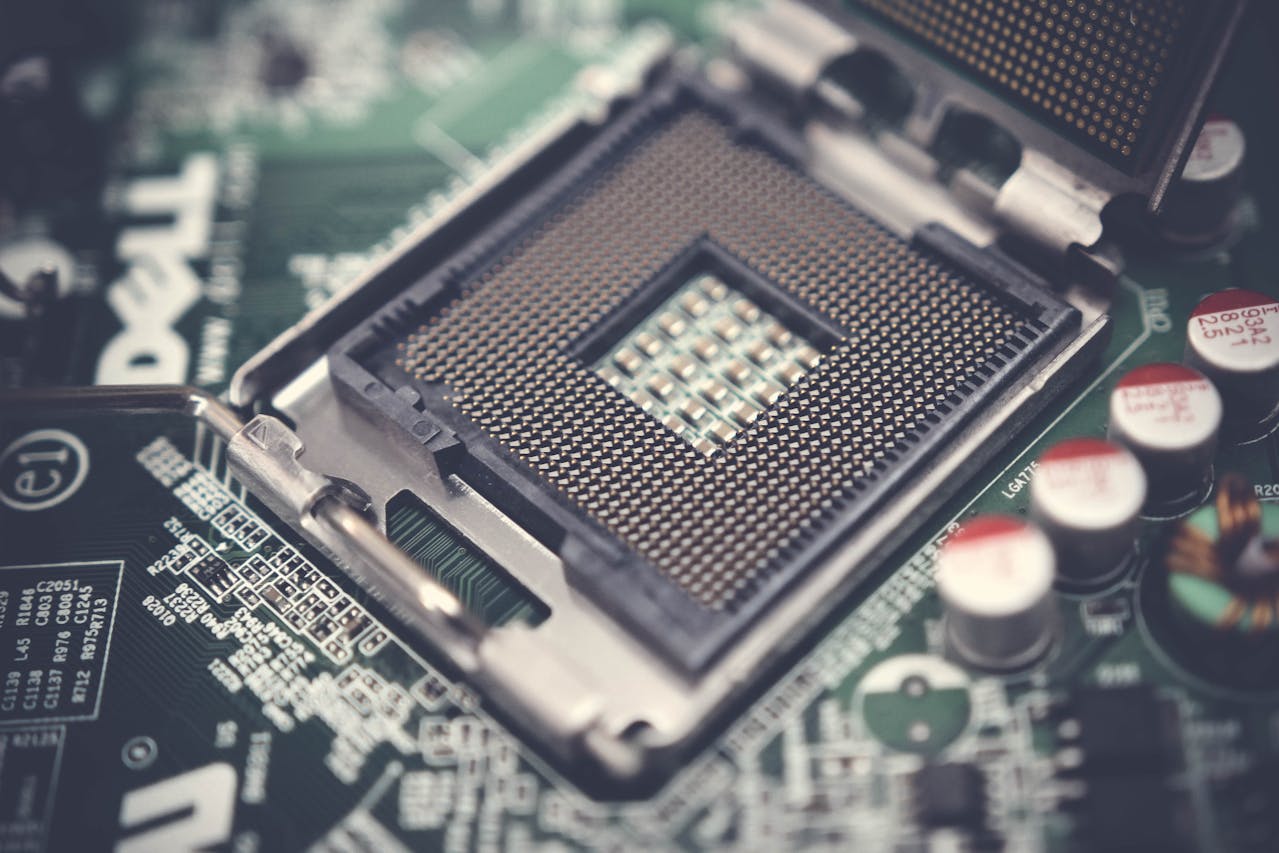

Równie ważne są fizyczne interfejsy – w komputerach stacjonarnych króluje PCIe, ale do urządzeń wbudowanych trafiają też moduły Mini PCIe, MXM, a nawet M.2. Dają one możliwość implementacji AI na mniejszych, energooszczędnych platformach.

Jak rozwiązywać typowe problemy z wyborem karty graficznej do AI?

Najczęstszy problem to zbyt mała ilość pamięci VRAM – modele nie mieszczą się i aplikacja wyłącza się z błędem. Rozwiązanie: wybierz kartę z co najmniej 16 GB VRAM lub zastosuj techniki batchowania danych.

Drugi kłopot to brak wsparcia frameworka AI (np. TensorFlow nie obsługuje danej platformy). Tu pomaga wybór rozwiązania zdojrzałego technologicznie – najlepiej pasującego do powszechnie wspieranych bibliotek, jak CUDA dla NVIDIA.

Inny problem to przegrzewanie karty – zbyt duże obciążenie w zamkniętej obudowie. Zadbaj o chłodzenie: odpowiedni przepływ powietrza i dobrą pastę termoprzewodzącą. Nie używaj AI na zintegrowanej grafice dłużej niż testowo – szybko osiągniesz limit.

Wskazówka: Jeśli nie chcesz wydawać na RTX 4090, to RTX 4060 Ti 16 GB to jedna z lepszych opcji startowych do AI – sprawdza się zaskakująco dobrze w Stable Diffusion.

Podsumowanie

Najlepsze karty graficzne do AI mają co najmniej 16 GB VRAM, wysoką przepustowość pamięci i obsługują technologie przyspieszające trenowanie i wnioskowanie modeli. W tej chwili to karty z rodziny NVIDIA GeForce RTX, a zwłaszcza RTX 4090 i RTX 4060 Ti 16 GB, gwarantują najlepszy rezultat w AI. AMD i Intel rozwijają ciekawe alternatywy, ale na razie nie dorównują topowym kartom GeForce. Wybór odpowiedniej karty może zmienić sposób, w jaki pracujesz z AI.

Jeżeli chcesz wycisnąć maksimum z projektów AI, dobrze dobrana karta graficzna to Twój pierwszy konkretny krok.

FAQ

Q: Czy da się szkolić modele AI na laptopie z kartą RTX 3060?

A: Tak, ale szybko trafisz na ograniczenia VRAM. RTX 3060 (6 GB lub 12 GB) nadaje się tylko do prostszych projektów.

Q: Co lepsze do AI – RTX 4070 czy AMD RX 7900 XTX?

A: RTX 4070 ma niższe zużycie energii i lepsze wyniki w AI mimo mniejszej pamięci VRAM, więc to bezpieczniejszy wybór.

Q: Czy zintegrowana grafika Intel Arc nadaje się do AI?

A: Tylko do testów i prototypowania. Jest kilka razy wolniejsza niż dedykowane GPU i ma za mało VRAM.

Opublikuj komentarz